量子计算机原理:从量子比特到量子优势的底层逻辑

2025.08.19 · 行业资讯 量子计算机原理量子计算机量子比特

在数字时代,计算机已经成为人类生产生活中不可或缺的工具。但随着人工智能、大数据等技术的飞速发展,传统计算机在处理复杂问题时逐渐显露出算力瓶颈。量子计算机作为一种基于量子力学原理构建的新型计算设备,正以其独特的运算方式为突破算力极限带来希望。本文将深入解析量子计算机的核心原理,带您了解这种 “未来计算设备” 的工作机制。

一、量子计算机的核心单元:量子比特的特殊性

传统计算机以二进制比特(Bit)作为信息处理的基本单位,每个比特只能处于 0 或 1 两种确定状态之一,就像一盏灯要么亮要么灭。而量子计算机的基本信息单元是量子比特(Qubit),它的神奇之处在于可以同时处于 0 和 1 的叠加状态,这是量子力学中 “叠加态” 原理在计算领域的直接应用。

打个通俗的比方:如果传统比特是一枚只能正面或反面落地的硬币,那么量子比特就是一枚正在旋转的硬币 —— 在停止旋转(即被测量)之前,它同时包含着正面和反面的可能性。这种叠加状态让量子计算机能够同时处理海量信息,理论上其算力会随着量子比特数量的增加呈指数级增长,而传统计算机的算力增长仅与硬件数量呈线性关系。

除了叠加态,量子比特还具有 “量子纠缠” 这一独特属性。当两个量子比特发生纠缠时,它们的状态会紧密关联在一起,无论相距多远,改变其中一个的状态,另一个的状态会瞬间发生相应变化。这种 “超距作用” 让量子计算机能够实现多量子比特的协同运算,进一步提升信息处理效率。

二、量子计算的底层逻辑:超越经典的运算模式

量子计算机的运算逻辑与传统计算机有着本质区别。传统计算机通过逻辑门(如与门、或门、非门)对二进制数据进行操控,运算过程是确定性的 “串行计算”。而量子计算机通过量子逻辑门对量子比特的叠加态进行操控,实现 “并行计算”。

在量子计算中,一个包含 n 个量子比特的系统可以同时表示 2^n 种状态,这意味着它能在一次运算中对 2^n 个数据进行处理。例如,当 n=20 时,量子计算机可同时处理超过 100 万个状态,而传统计算机需要逐个处理这些状态,耗时会大幅增加。这种并行处理能力让量子计算机在大数分解、数据库搜索等问题上展现出巨大优势。

不过,量子计算的结果并非直接可得。由于量子测量会导致叠加态 “坍缩”,量子计算机的运算结果需要通过多次测量才能得到可靠数据。科学家们通过设计特殊的量子算法(如 Shor 算法、Grover 算法),能够从概率性的测量结果中提取有效信息,实现对复杂问题的高效求解。

三、量子计算机的核心技术组件

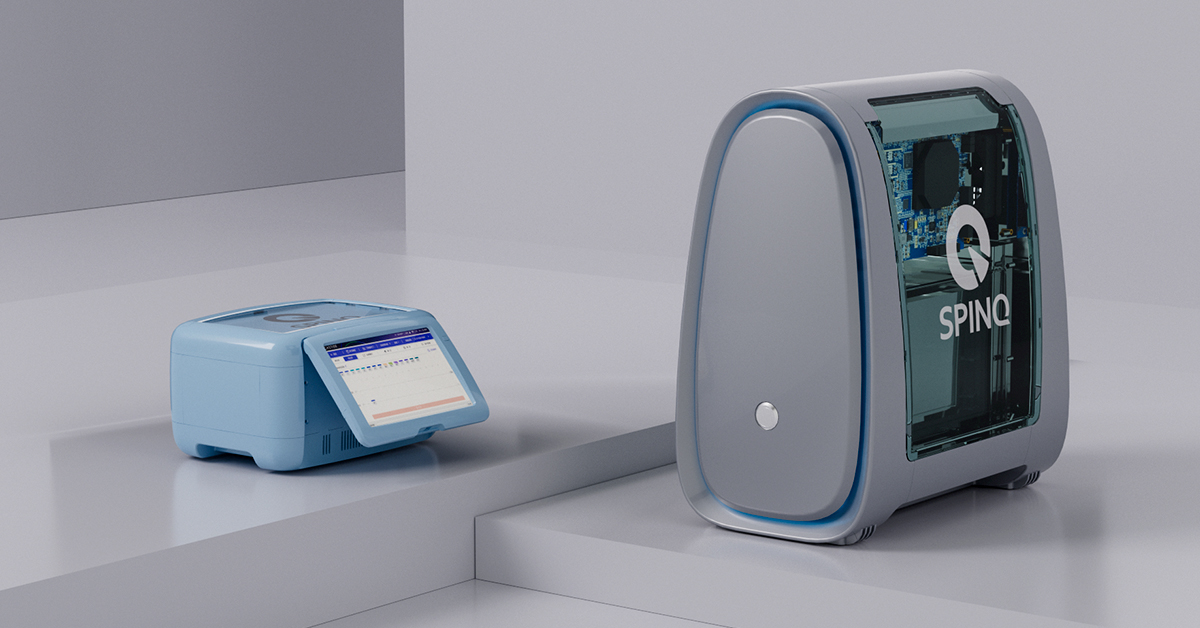

要实现量子计算的核心原理,需要一系列精密的技术组件作为支撑。量子处理器是量子计算机的 “大脑”,负责搭载量子比特并执行量子逻辑运算。目前主流的量子处理器有超导量子处理器、离子阱量子处理器、光量子处理器等,不同类型的处理器基于不同的物理体系实现量子比特的操控。

量子纠错技术是保障量子计算可靠性的关键。量子比特非常脆弱,容易受到环境噪声(如温度、电磁干扰)的影响而失去量子特性,这种现象被称为 “退相干”。量子纠错通过多量子比特的协同工作,能够检测并修正运算过程中的错误,延长量子态的稳定时间。

此外,量子计算机还需要极低温度的运行环境(如超导量子计算机需要接近绝对零度的温度)、高精度的操控设备(如激光脉冲、微波脉冲发生器)以及复杂的控制系统,这些组件共同构成了量子计算的硬件基础,支撑着量子力学原理在计算中的实际应用。

四、量子计算机原理的实际应用场景

理解量子计算机原理,有助于我们把握其未来的应用方向。在密码学领域,基于大数分解难题的 RSA 加密算法在量子计算机面前将不再安全,因为 Shor 算法能利用量子并行计算能力快速分解大整数;而量子密钥分发技术则基于量子不可克隆原理,能实现绝对安全的通信加密。

在材料科学和药物研发中,量子计算机可以精确模拟分子的量子行为,帮助科学家设计新型催化剂、研发抗癌药物等,大幅缩短研发周期。在人工智能领域,量子机器学习算法能利用量子并行性处理海量数据,提升模型训练效率和预测精度。

结语

量子计算机原理的核心在于对量子叠加态和纠缠态的巧妙运用,这种基于量子力学的计算模式打破了传统计算机的算力局限。虽然目前量子计算机还处于发展初期,面临着退相干、量子纠错等技术挑战,但随着研究的不断深入,它必将在密码学、材料科学、人工智能等领域发挥革命性作用。了解量子计算机原理,不仅能让我们把握科技发展的前沿方向,更能让我们感受到量子世界的奇妙与魅力。

.jpg)